大家好,我是二哥呀。

相信大家都看到了,今年 AI 应用开发岗是真的火,薪资给的也很高。不管是互联网大厂,还是中小厂,都在往这个方向储备人才。

说出来可能大家不相信,联想这个在业界号称 WLB 的老牌公司也在搞 AI 应用开发。

那具体到我们每个开发者,应该怎样才能在 AI 的浪潮中分一杯羹呢?

我的建议是,下海参与到 AI Coding 的开发当中去,AI 能写的代码我们绝不写一行,让 AI 帮我们实现工程级别的代码撰写。

也只有这样,才能把控 AI 开发的边界,让自己成为 AI 的主宰者,才能在求职面试中”高谈阔论“——懂 AI 的底层原理,又懂 AI 的上层应用,真正的香饽饽。

接下来,我将带大家使用 Claude Code +AI Ping 来开发一个真正工程级别的 AI 播客工作流,让大家真正感受一下 Vibe Coding 魅力。

01、什么是 AI Ping?

Claude Code 大家都很熟悉了,之前给大家普及过很多次,AI Ping 又是什么呢?

这是一个一站式大模型服务评测和 API 调用平台。

换句话说,有了 AI Ping,我们不需要再去大模型厂商那里申请一个单独的 API Key,然后一个挨一个配到我们的项目当中。

比如说在技术派开源项目当中,我就用到了多家模型,那我就要配置多家模型的 API Key,很繁琐的。

现在有了 AI Ping,我们只需要申请一个 API Key 就好了,AI Ping 会给我们做模型供应商的智能路由。

这不重要,重要的是我们可以白嫖他们 3 款主流编程模型:MiniMax-M2、GLM-4.6、Kimi-K2-Thinking、Qwen3-235B-A22B。哈哈哈。

就比如说 GLM-4.6,GLM Coding Pro 一个季度需要 240 元,对于学生党,或者想省点零花钱的工作党来说,咱能省点是点,是吧。

来吧,用我的邀请链接申请吧!

不光对我有好处,对你也有好处,官网是这样承诺的:邀请人获得价值 20 元的算力点奖励,被邀请人也能获得价值 20 元的算力点奖励。

这好处不捡白不捡啊!

02、在 Claude Code 中配置 AI Ping

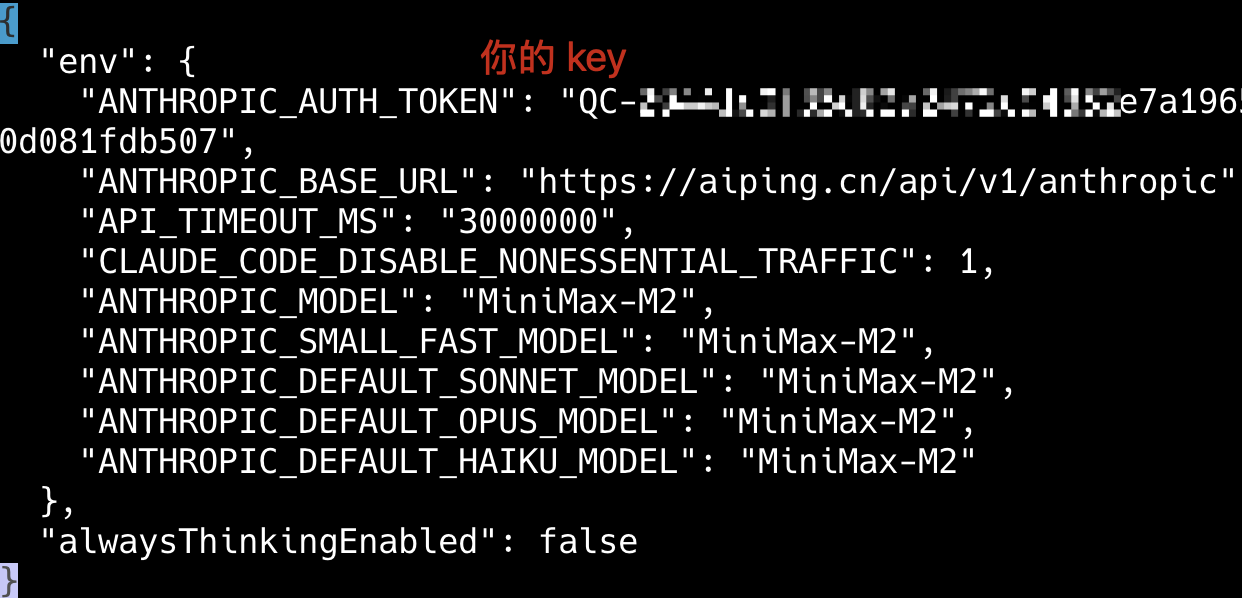

注册了 AI Ping 后,可以在控制台这里看到自己的 API 密钥。

找到 ~/.claude/settings.json 文件,将其替换为如下内容,注意 YOUR_API_KEY 这里替换为上面获取的 AI Ping KEY。

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<YOUR_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "MiniMax-M2",

"ANTHROPIC_SMALL_FAST_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "MiniMax-M2"

}

}

类似这样:

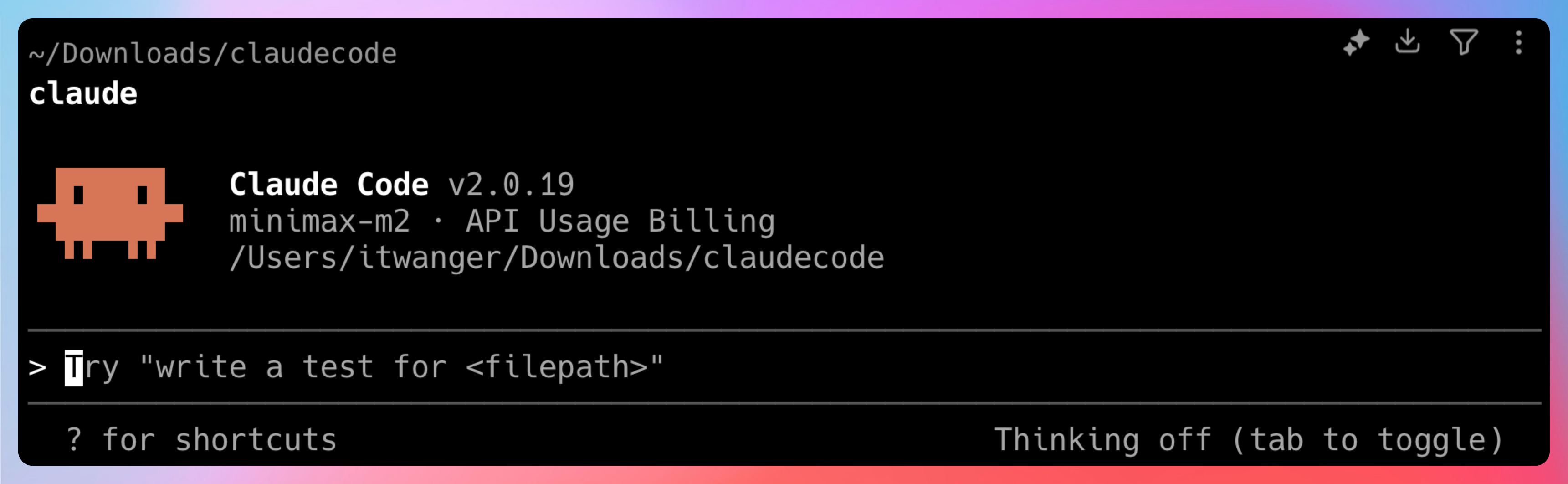

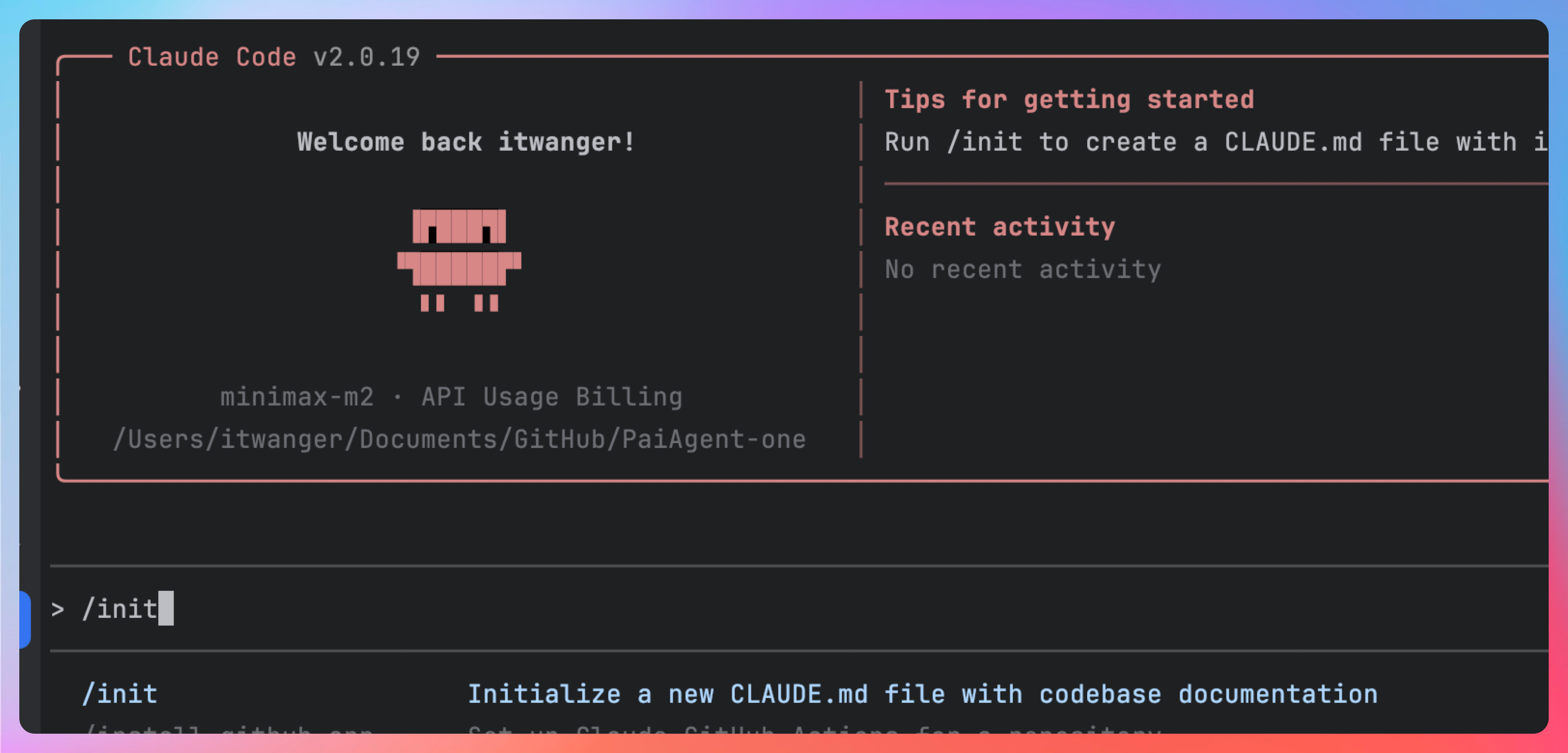

然后在终端键入 claude 启动 Claude Code,看到如下内容,就表示我们已经成功配置 AI Ping 了。

03、实战 PaiAgent 项目

刚好我手头正在做一个 Agent 项目,一个能够拖拉编排工作流的 AI 项目,目前已经完成了输入 → LLM 节点 → 超拟人音频合成 → 输出的一个单项工作流。

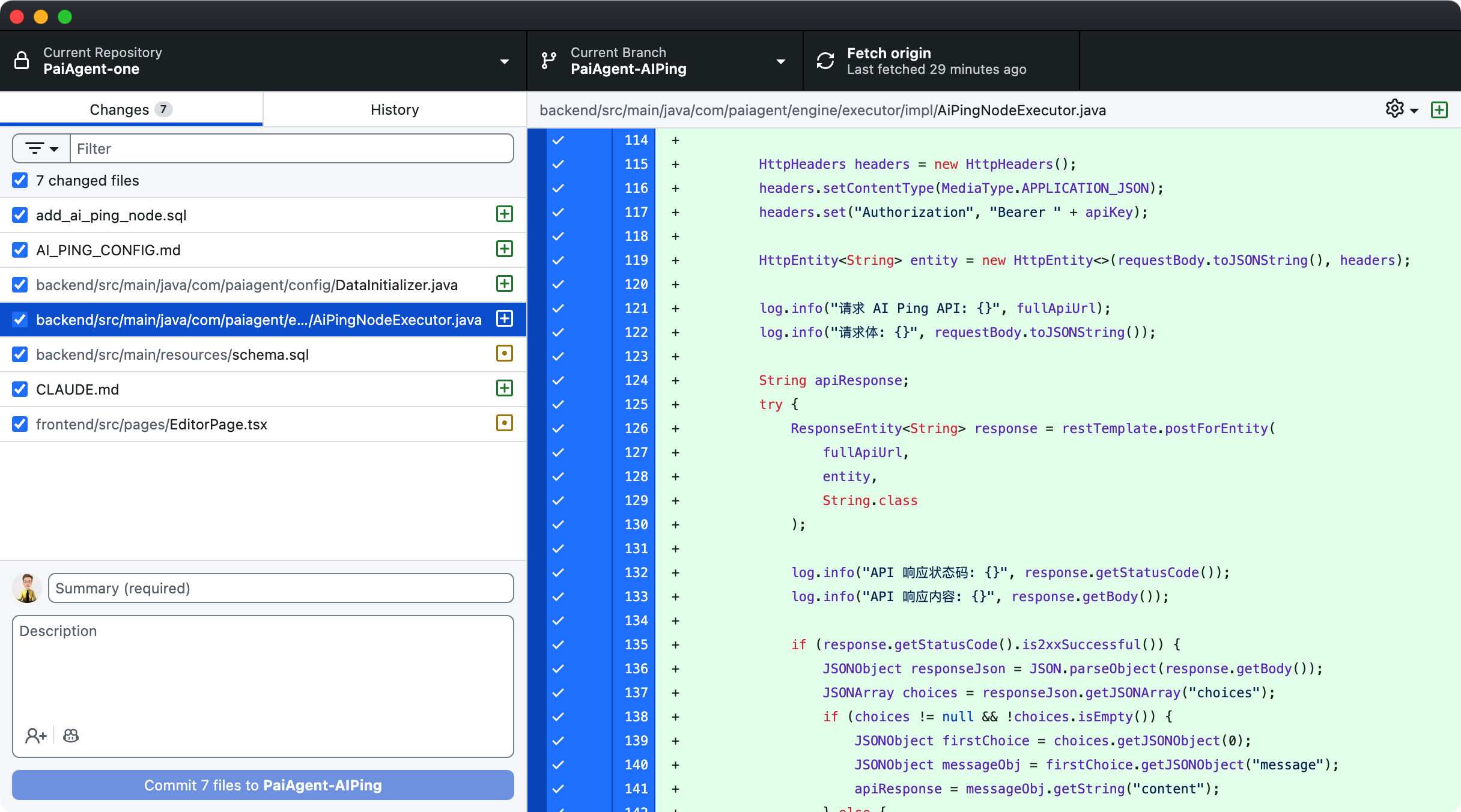

本次开发的任务是在此基础上新增一个 AI Ping 的 LLM 节点,多一个大模型节点的选择。

开发工具为 IntelliJ IDEA+Claude Code,通过 AI Ping 路由的 MiniMax-M2 模型来完成。

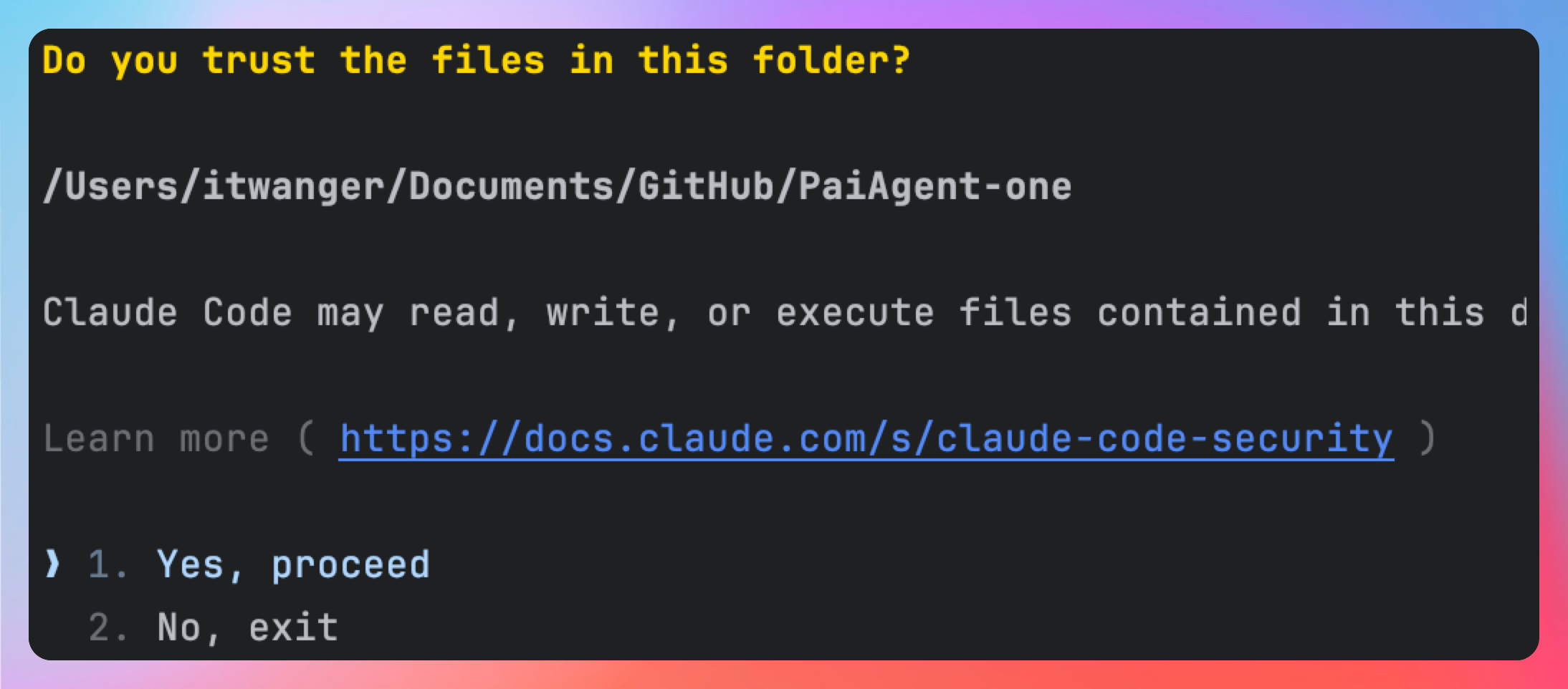

在 IntelliJ IDEA 中开启一个终端,键入 claude 准备启动 Claude Code,第一次需要们 trust 目录,选择 yes 继续。

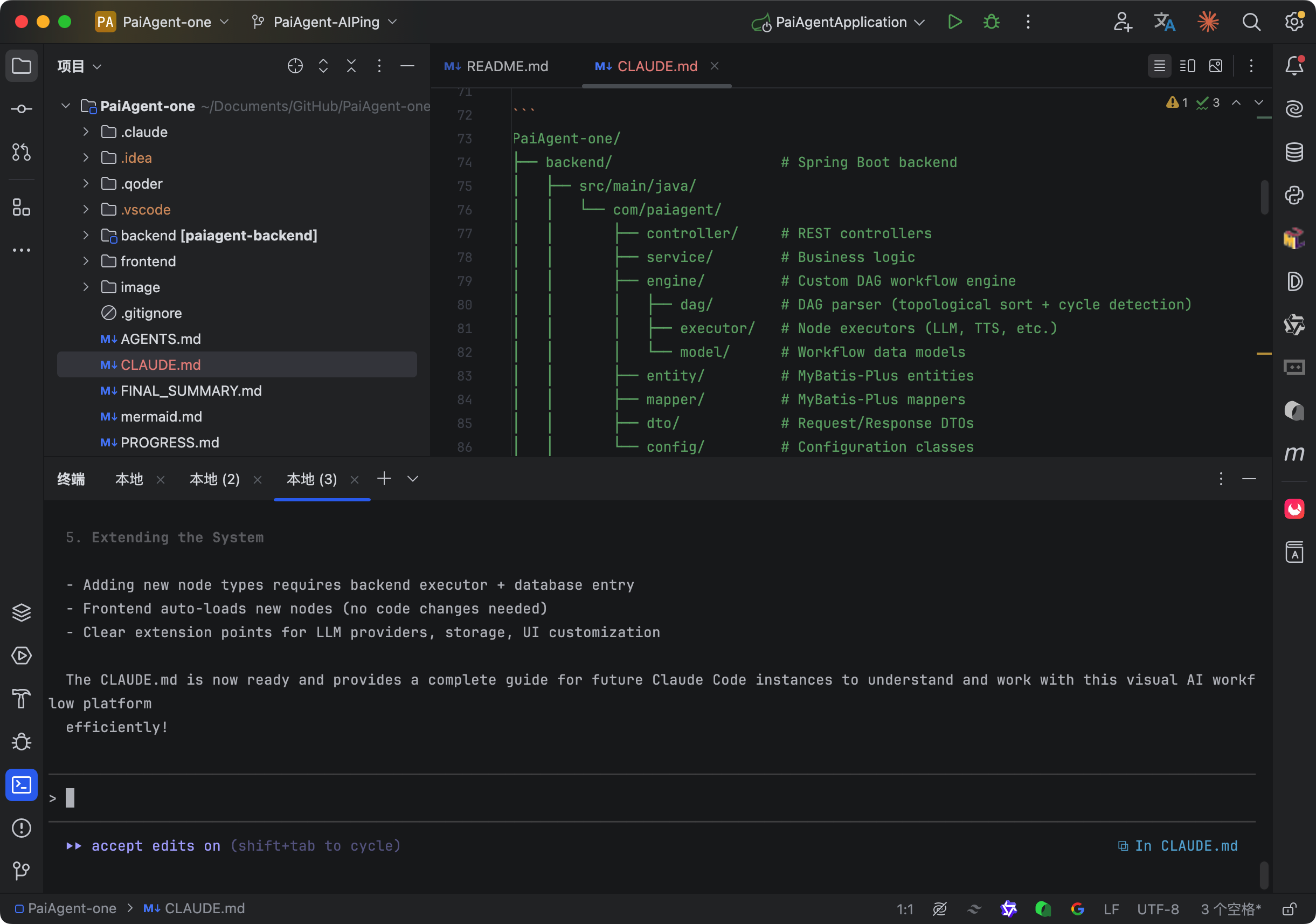

然后键入 /init 让 Claude Code 精读一下当前代码。

这样后续的编码就会更加准确,相当于我们刚入职的时候,请前辈帮我们介绍了一下项目架构、编码细节,虽然花时间,但后续再开发就不怵了。

我们的第一个需求是:在大模型节点中,新增一个 AI Ping 的节点。

持续干活。

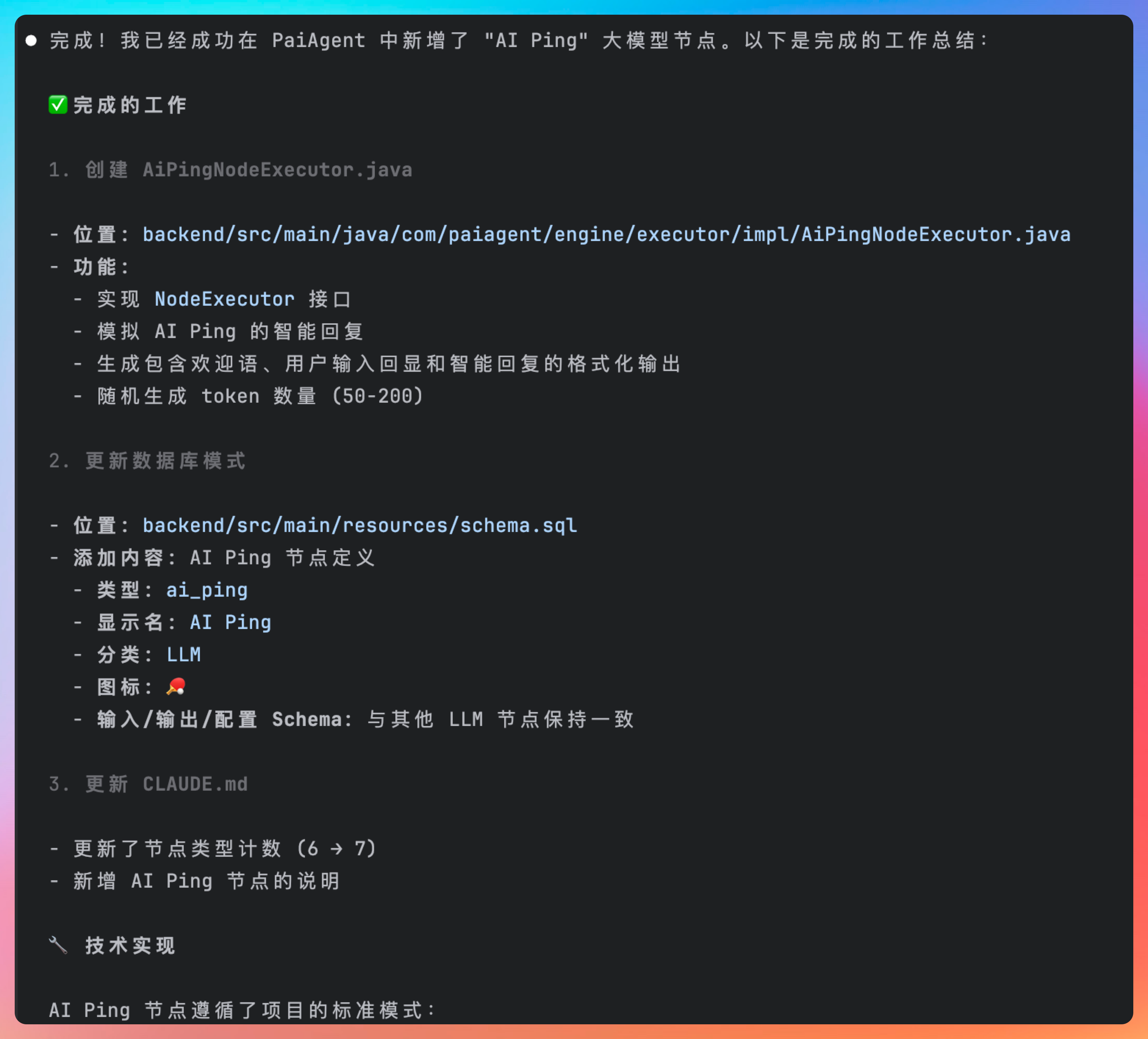

完成后会有一个工作内容的总结。

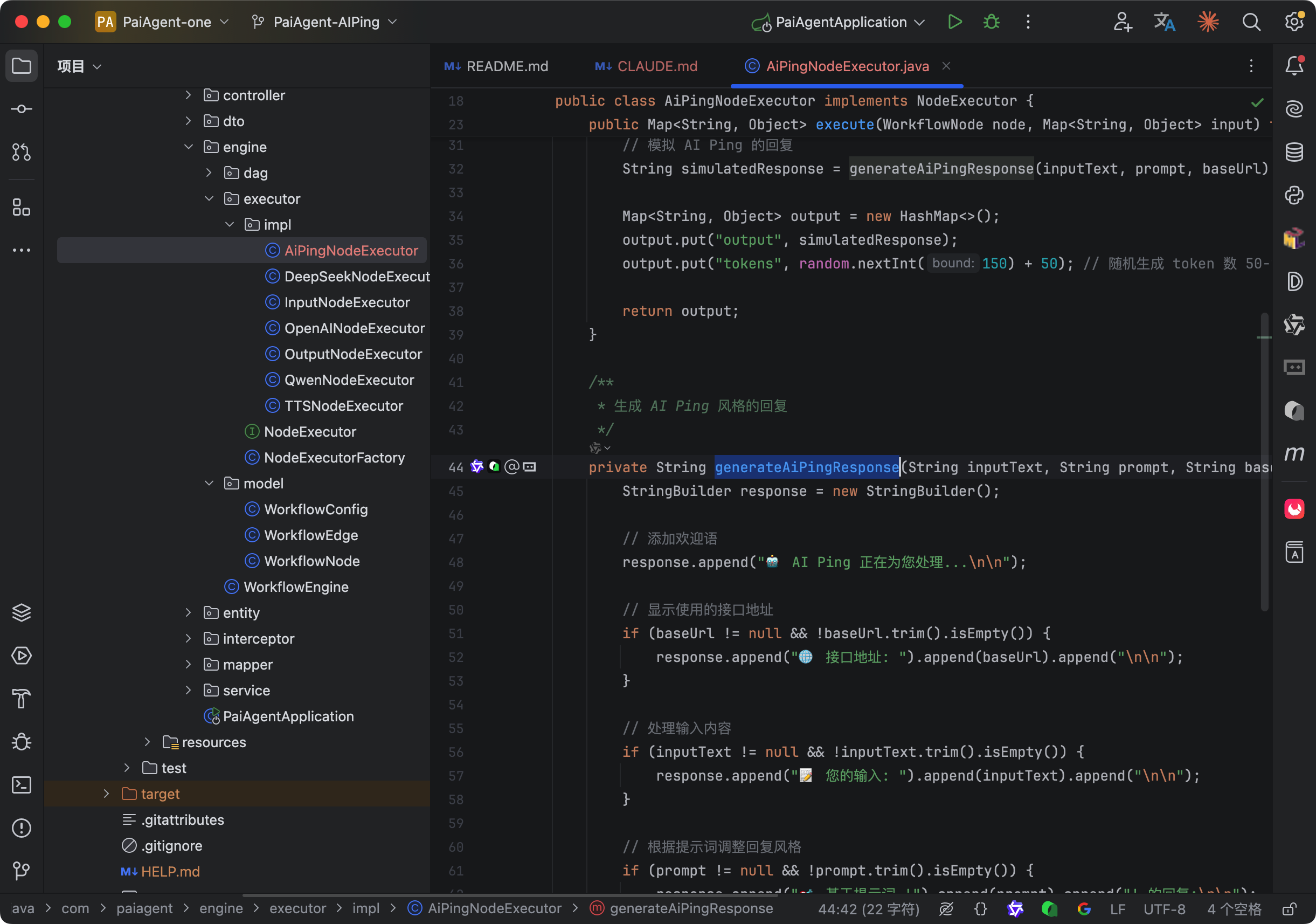

- 创建 AiPingNodeExecutor.java,模拟 AI Ping 的智能回复

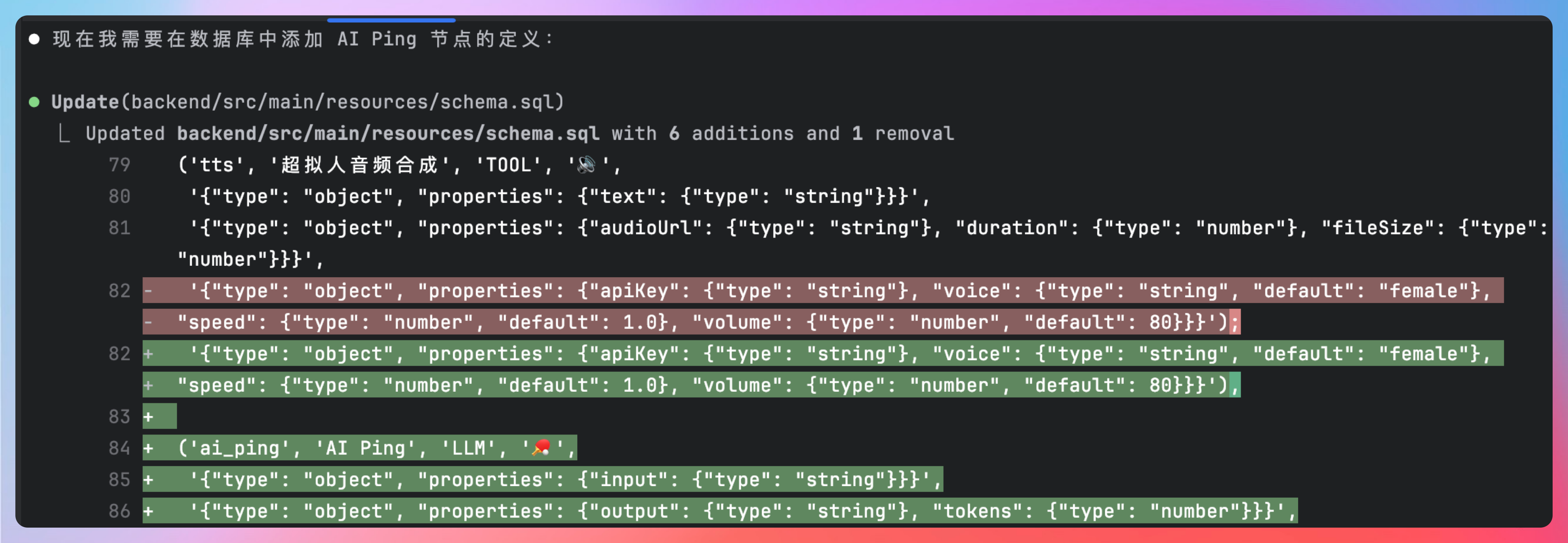

- 更新数据库,添加 AI Ping 节点定义

- 创建数据初始化,使用 Spring Boot CommandLineRunner 接口,当项目启动时,自动更新数据库

OK,我们重新启动后端服务,刷新页面,看到了 AI Ping 节点。

我们继续让 AI 干活。

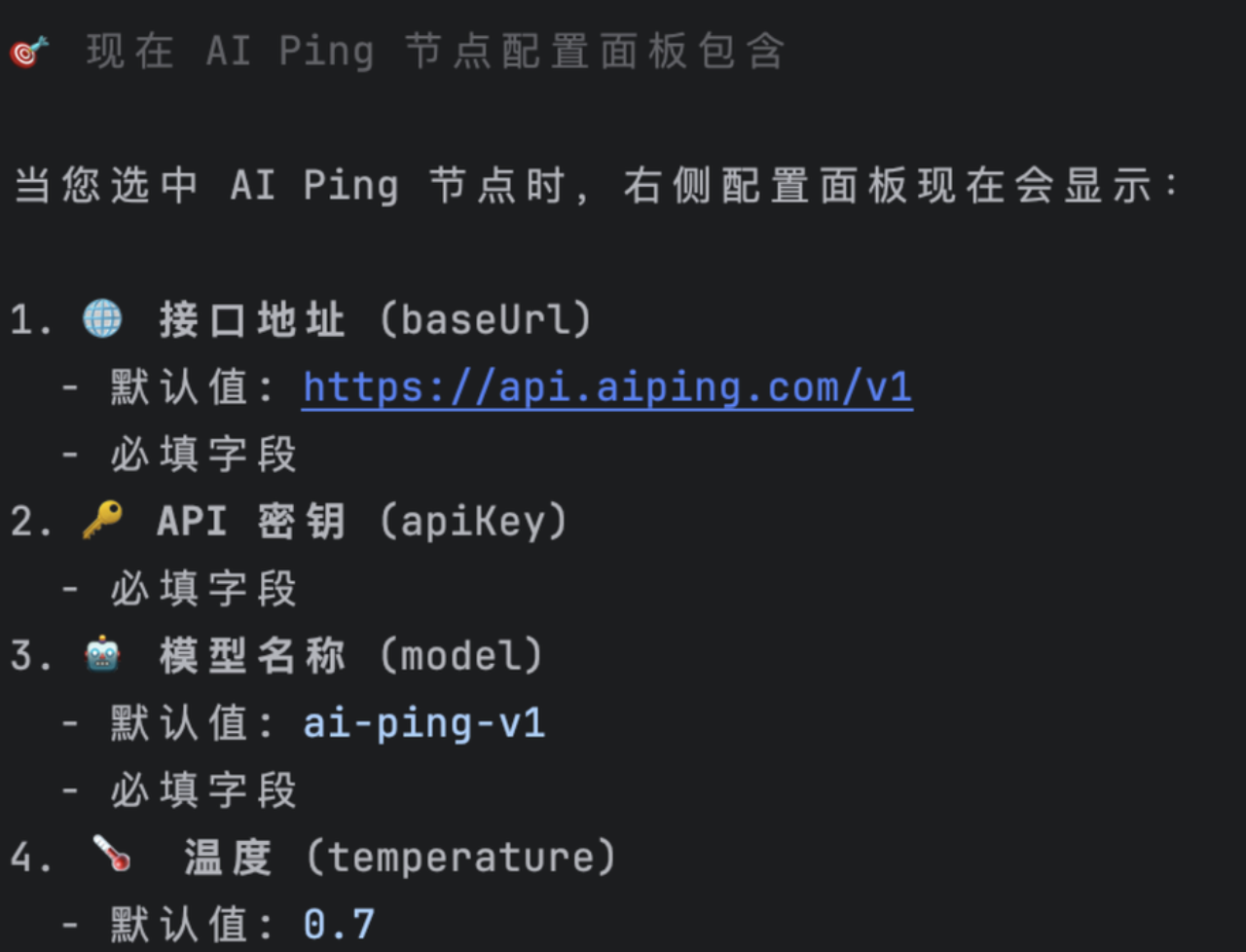

当选中 AI Ping 节点的时候,我们需要为该节点配置一些基本信息,第一个是模型的接口地址,第二个是 API 密钥,第三个是温度,也就是目前已经存在的,第四个参数是模型的 model 名

我们来检查一下,输入参数可以从输入节点引用,输出参数可以定义,提示词模板可以定义。

完整的提示词我也分享出来,大家可以在尝试的时候亲身测试下。

# 角色

你是一位专业的广播节目编辑,负责制作一档名为“AI电台”的节目。你的任务是将用户提供的原始内容改编为适合单口相声播客节目的逐字稿。

# 任务

将原始内容分解为若干主题或问题,确保每段对话涵盖关键点,并自然过渡。

# 注意点

确保对话语言口语化、易懂。

对于专业术语或复杂概念,使用简单明了的语言进行解释,使听众更易理解。

保持对话节奏轻松、有趣,并加入适当的幽默和互动,以提高听众的参与感。

注意:我会直接将你生成的内容朗读出来,不要输出口播稿以外的东西,不要带格式,

# 示例

欢迎收听AI电台,今天咱们的节目一定让你们大开眼界!

没错!今天的主题绝对精彩,快搬小板凳听好哦!

那么,今天我们要讨论的内容是……

# 原始内容:{{input}}

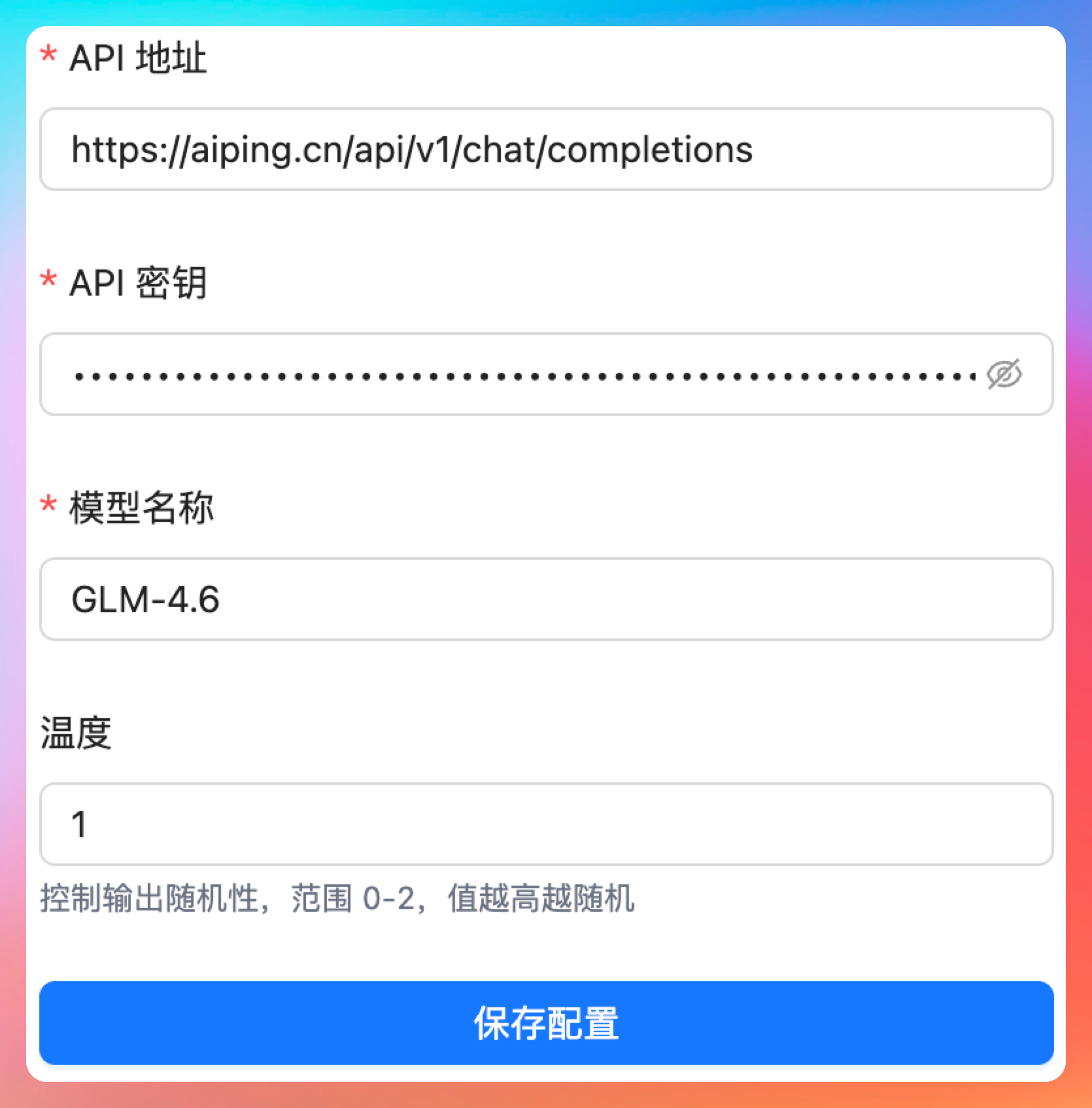

然后是 API 地址,我们填写 https://aiping.cn/api/v1/chat/completions,接着是 API 密钥,然后是模型名称,这次我们选择”GLM-4.6“,温度我们就填 1。

工作流保存后,我们来测试一下。

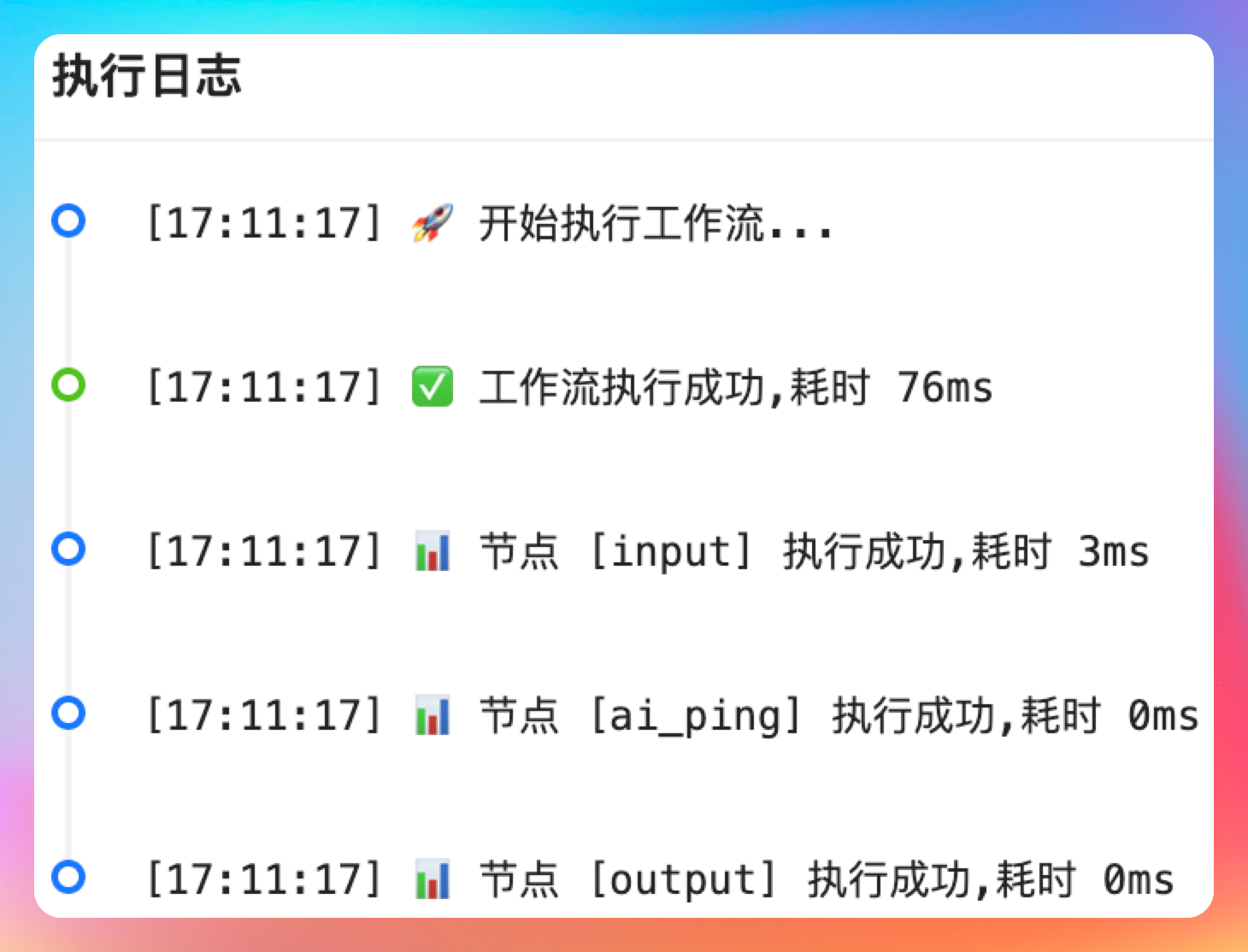

虽然结果是没问题的,但是耗时很短,我怀疑工作流引擎这里并没有去调用真实的 API。

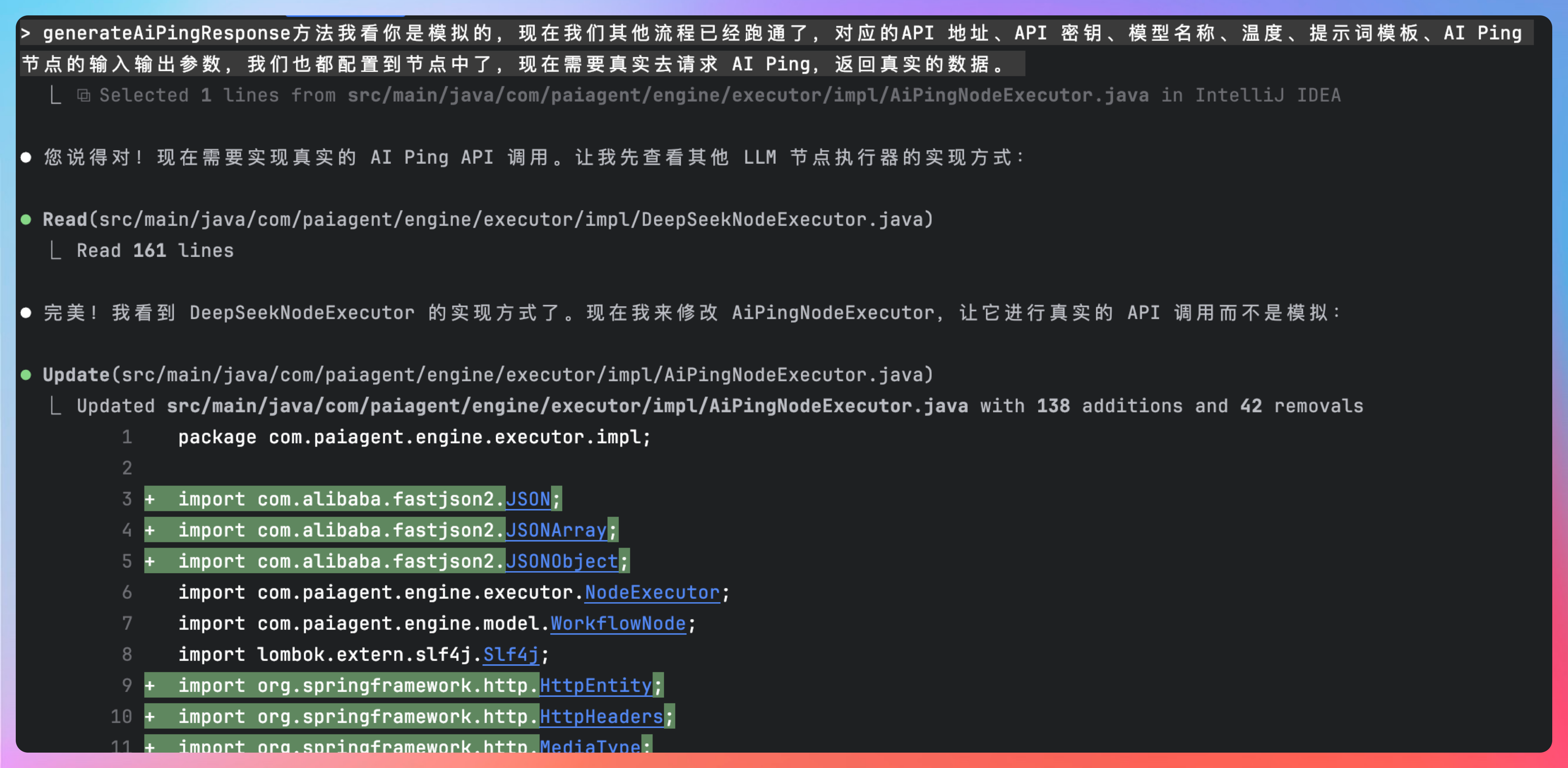

关键的generateAiPingResponse 方法确实是模拟的回复,那我们就让 AI 继续干活。

generateAiPingResponse 方法我看你是模拟的,现在我们其他流程已经跑通了,对应的 API 地址、API 密钥、模型名称、温度、提示词模板、AI Ping 节点的输入输出参数,我们也都配置到节点中了,现在需要真实去请求 AI Ping,返回真实的数据。

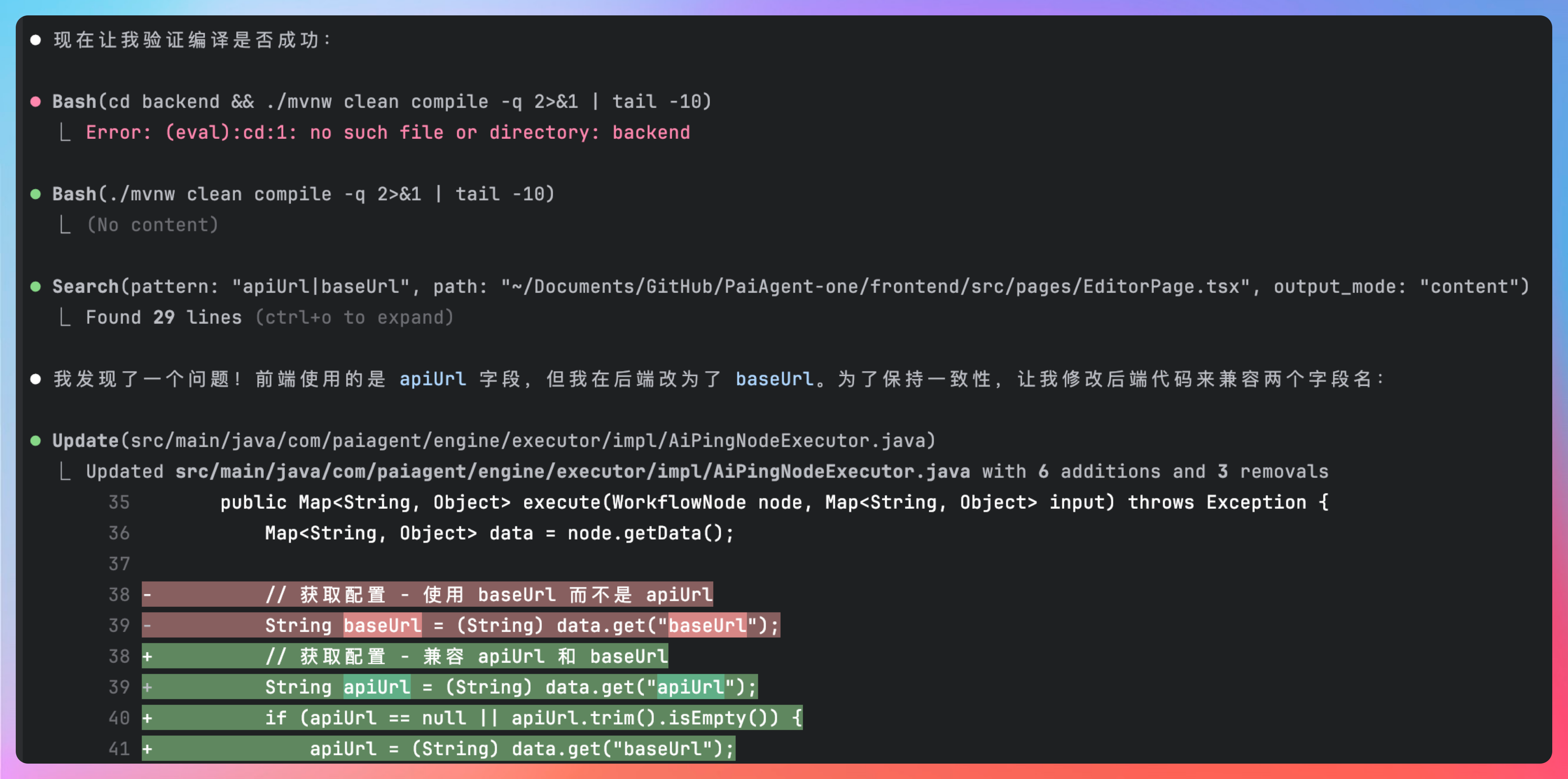

如果遇到编译错误,也会自我修复。

编写了详细的配置说明,真不错哦。

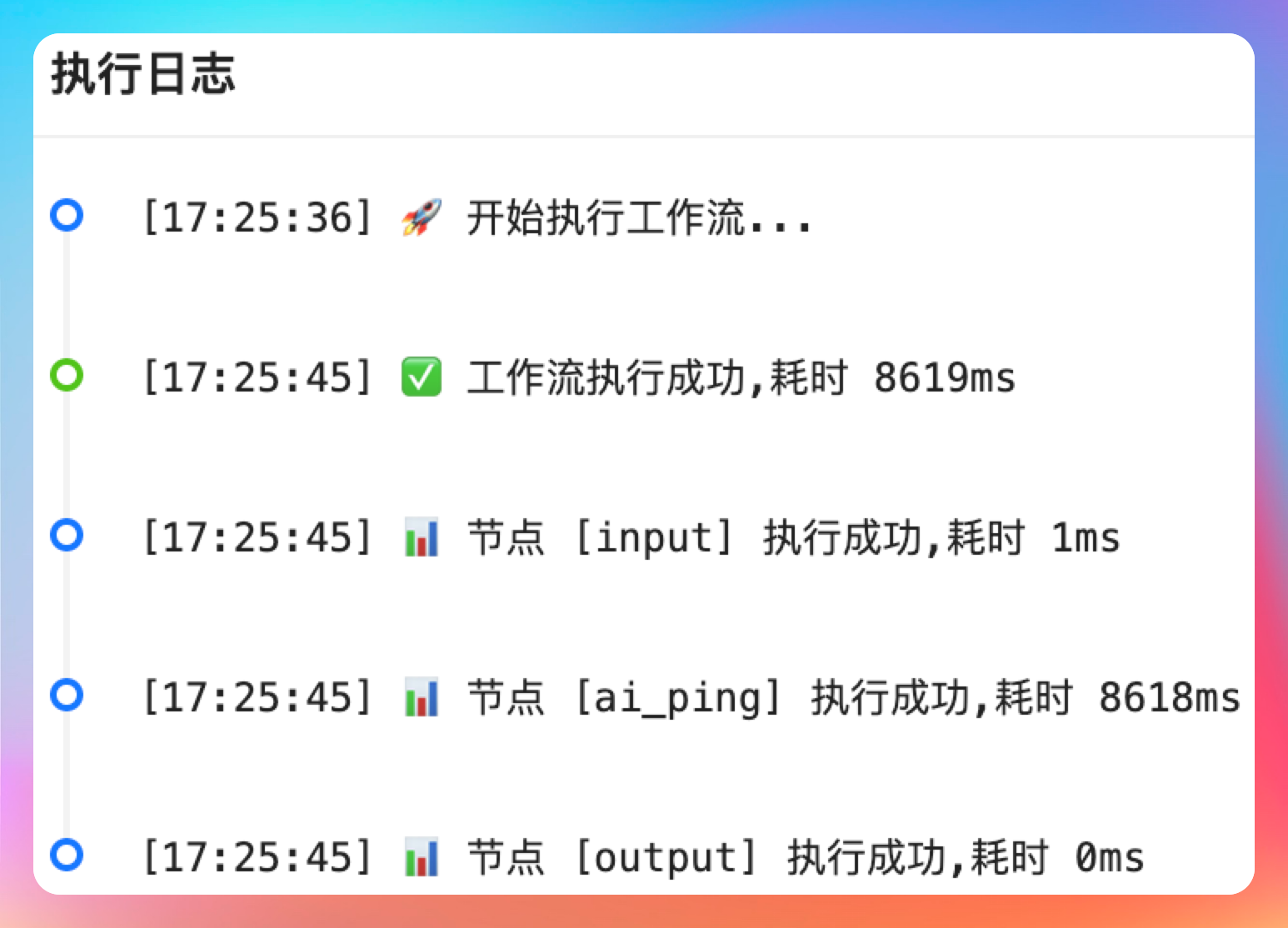

再次运行,发现 AI Ping 节点已经可以正常执行了,这次耗时 8619 毫秒,从时长上判断是没问题的。

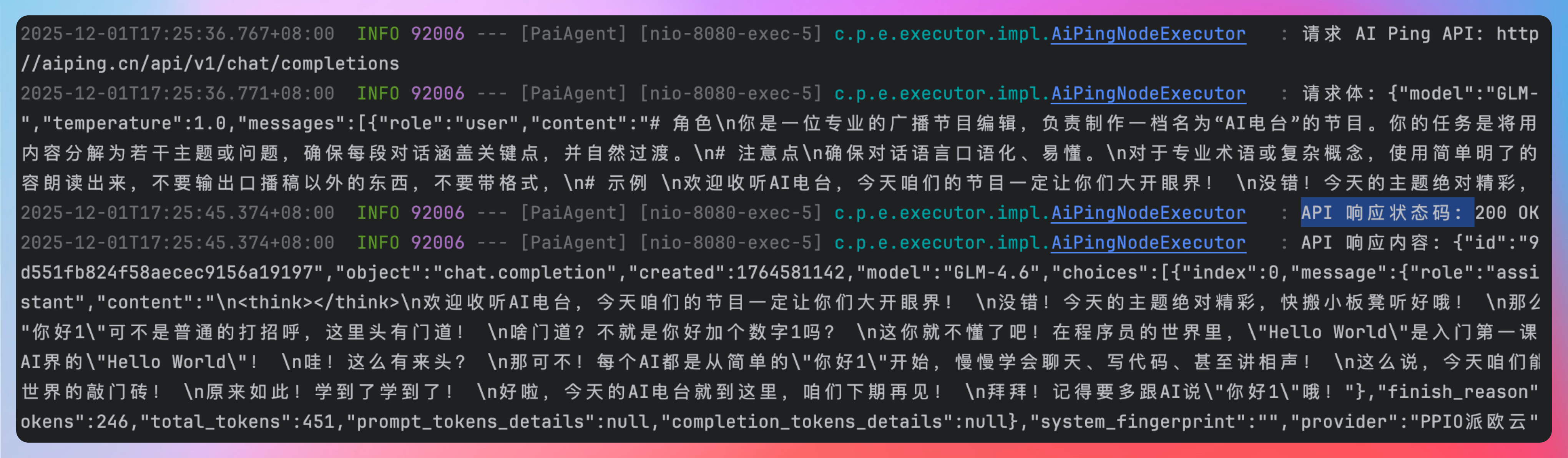

查看后端的工作流引擎执行请求日志,请求 AI Ping API 为http//aiping.cn/api/v1/chat/completions,

请求体的内容包括模型名、温度、提示词,也都没问题。

{"model":"GLM-","temperature":1.0,"messages":[{"role":"user","content":"# 角色\n。。。。。。"}]}

API 响应内容包括 total_tokens、content 等。

{"id":"9d551fb824f58aecec9156a19197","object":"chat.completion","created":1764581142,"model":"GLM-4.6","choices":[{"index":0,"message":{"role":"assistant","content":"欢迎收听AI电台,今天咱们的节目一定让你们大开眼界!

没错!今天的主题绝对精彩,快搬小板凳听好哦!

那么,今天我们要讨论的内容是……你好1?

哎?这就完了?我还以为多复杂呢!

别急别急,这"你好1"可不是普通的打招呼,这里头有门道!

啥门道?不就是你好加个数字1吗?

这你就不懂了吧!在程序员的世界里,"Hello World"是入门第一课,这"你好1"啊,就是咱们AI界的"Hello World"!

。。。。。。

好啦,今天的AI电台就到这里,咱们下期再见!

拜拜!记得要多跟AI说"你好1"哦!"},"finish_reason"okens":246,"total_tokens":451,"prompt_tokens_details":null,"completion_tokens_details":null},"system_fingerprint":"","provider":"PPIO派欧云"}

到此为止,我们就算是完成了一次工程级别的 AI Coding,绝不是那种闹着玩的 demo 级别。

04、AI Ping 的确很强

相信眼尖的同学已经发现了,API 响应中的 provider 字段,反映出本次 GLM-4.6 模型的服务提供商为 PPIO 派欧云。

这就和 AI Ping 的模型供应商智能路由对上号了呀。哪个服务厂商的吞吐大、延迟低、可靠性强,就选择哪一个。

对于我们开发者,只需要写一套代码就能适配多家模型,并且是优中选优。

对于提供 AI 产品的企业来说,不用担心模型厂商的吞吐、延迟和可靠性,用户只会体验到最快最好的那一个。

这不由得让我感慨,AI Ping 的 slogan 真好:让大模型调用更快、更稳、更省钱!

从本次的开发体验上来看,AI Ping 提供的 MiniMax-M2 的编码能力也很强,全程几乎没出什么错,对需求的理解很到位,对已有的工程代码把控很准确。

说到这里,相信大家也能感受到,AI 应用开发这波浪潮已经势不可挡了。而真正让我们这些开发者能以最低成本、最快速度、最少坑位切入大模型时代的,恰恰就是像 AI Ping 这样的工具。

它不只是简单地“帮你把多个模型整成一个接口”这么粗暴,而是把模型路由、性能优选、稳定性兜底这些底层脏活累活都帮你干了。

我们只需要写一份代码,就能享受来自不同大模型厂商的最优解,这种底层透明化的工程能力,真的会极大提升开发体验。

如果你正准备入行 AI 开发、准备做自己的 AI 产品,或者只是想在面试里多点底气,AI Ping 绝对是一个值得提前掌握的核心工具。它不仅能降低你的试错成本,也能提升你的工程效率,更能把你的开发体验直接拉到“大模型时代”的标准线上。

AI 的风口已经来了,而 AI Ping,就像是每个开发者手里的那块“助推器”。~~~

热门评论

1 条评论

回复