蛇年最大的信息差就是 deepseek,所以我在本地也部署了 deepseek,并且使用 anythingllm 投喂了面渣逆袭 PDF 版本,这里就给球友们普及一下。

没什么华丽的技巧,非常简单易懂。

PDF 格式下载 https://pan.baidu.com/s/1xzbtEiFIBDBBWrdKn9s5nQ?pwd=gd8r

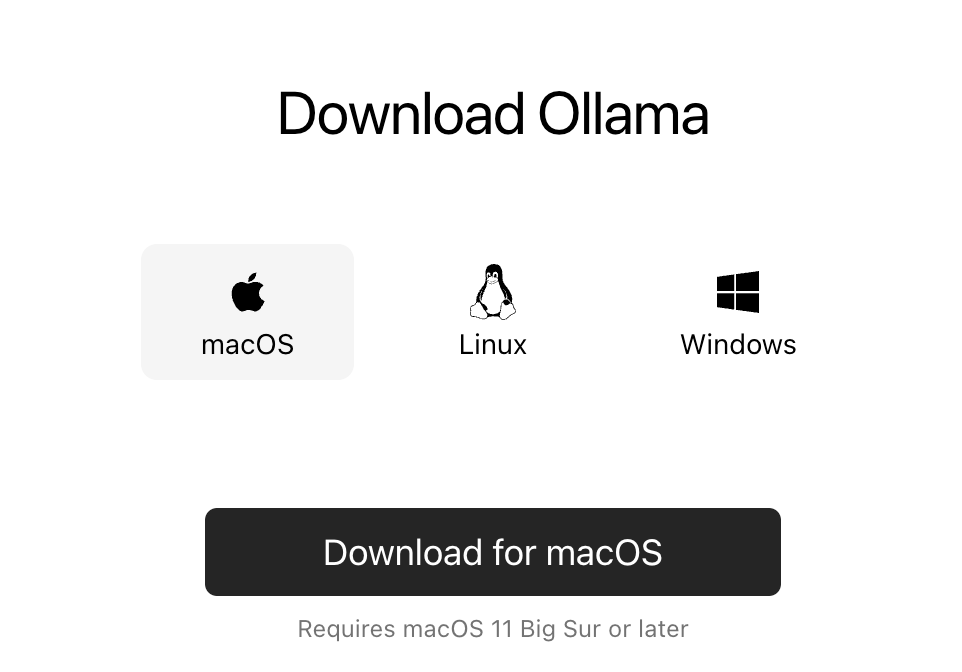

第一步,安装 ollama

Ollama 是一个本地运行大语言模型(LLM)的工具,支持 DeepSeek、Llama、Mistral 等开源 AI 模型,允许用户在本地推理和交互。

能够提供高效的模型管理、轻量级 API,并支持CPU 和 GPU 加速。相比云端 API,Ollama 更安全、可离线运行,适用于本地开发、私有数据处理和 AI 应用开发。

下载地址:https://ollama.com/download/mac

我本机是 macOS,如果你是 Windows,下载 Windows 版本就可以了。

下载完成后,macOS 是不需要安装的,双击就可以解压,把 App 拖到应用程序当中就可以了。

双击。

就完成了 ollama 的运行,注意没有任何界面。

可以在导航栏看到这个可爱的小图标,就表示 Ollama 已经成功运行了。

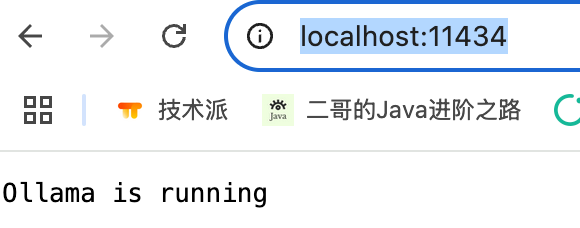

也可以在浏览器输入 http://localhost:11434/,查看运行状态。

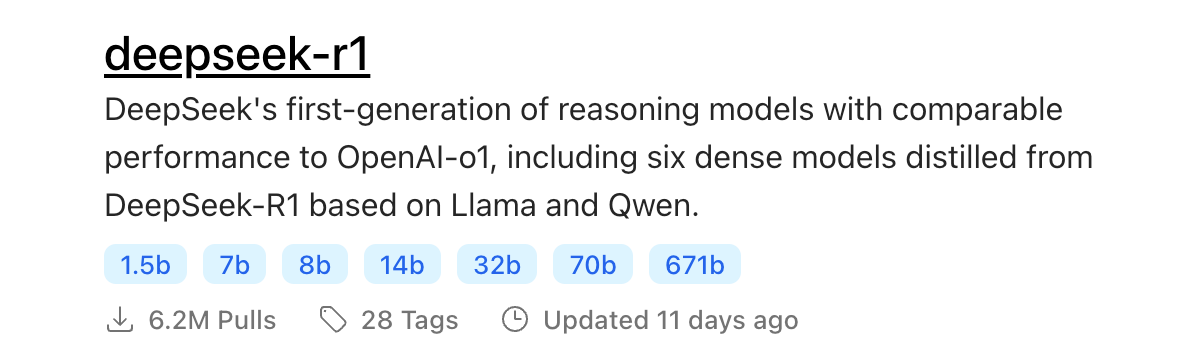

第二步,拉取deepseek-r1 模型

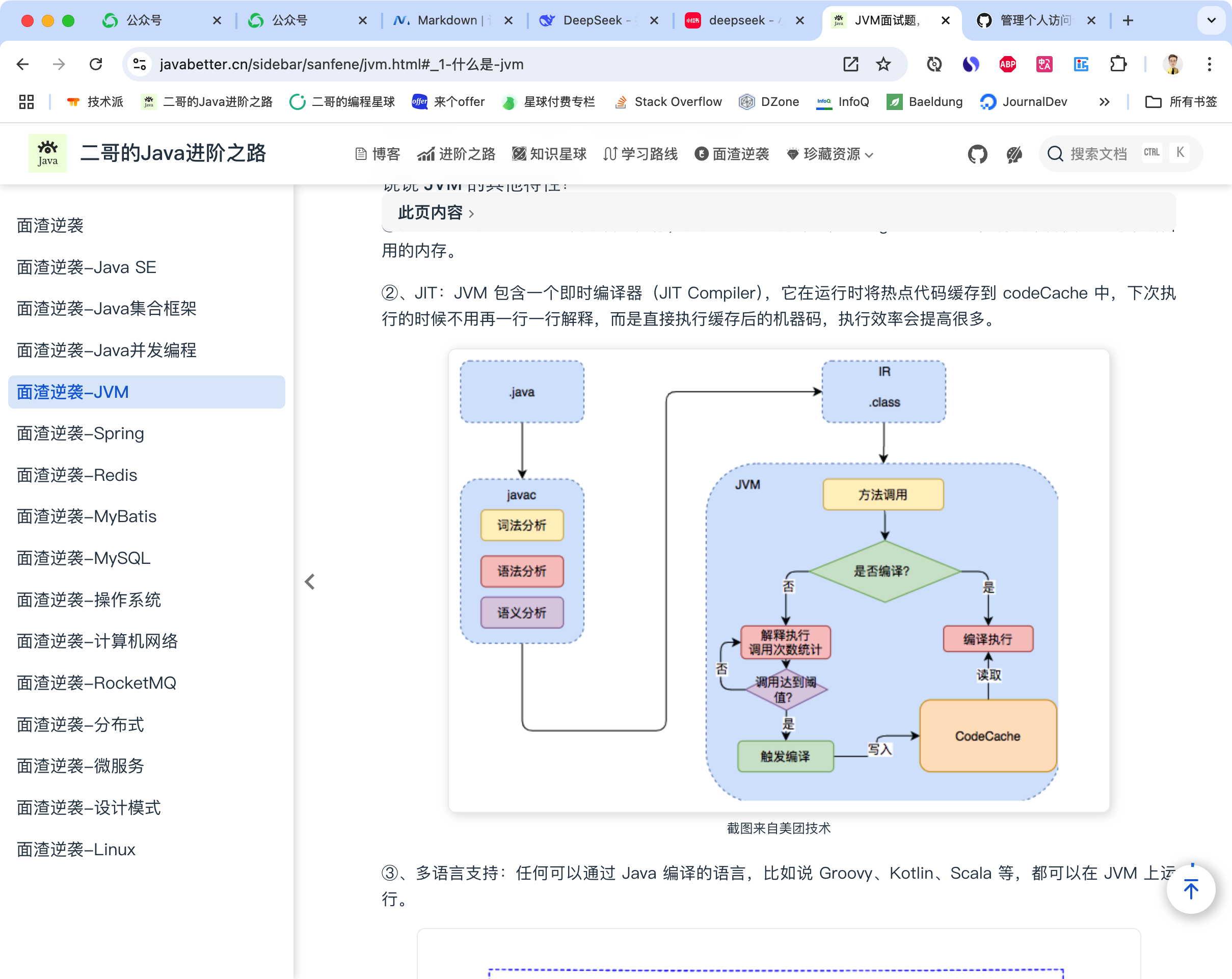

DeepSeek-R1 是 DeepSeek 团队推出的一款开源、支持 128K 长文本上下文的 Transformer 大语言模型,在代码生成、数学推理等任务上表现出色。

ollama 支持 deepseek 的全尺寸版本,比如说 1.5b、7b、8b、14b 等,本地建议安装 7b 版本,体积大小最合适。

然后在控制台输入 ollama run deepseek-r1:7b 运行,我家的网速很一般,这里拉取模型花了不少时间。

截图这会有 2.5M/s,但不是很稳定,慢的时候只有 300 多 kb,所以这一步需要花时间耐心等一下。

我差不多是花了一个晚上才搞定,截图都到第二天了,非常消耗耐心。

等 deepseek 拉取完成后,就可以在控制台进行交互了,直接输入文本进行提问就可以了。

第三步,安装anythingllm

AnythingLLM 是一个开源的本地 LLM(大语言模型)管理和知识库平台,可以让用户轻松将文档、网页、数据库等数据接入到本地或远程大模型(如 Ollama、GPT、DeepSeek 等),实现自定义的 AI 助手。

它支持多数据源整合、私有化部署,并提供 Web 界面 和 API,适用于企业知识管理、自动化客服、AI 辅助研究等场景。

直接通过 https://anythingllm.com/desktop 就可以下载桌面版本。

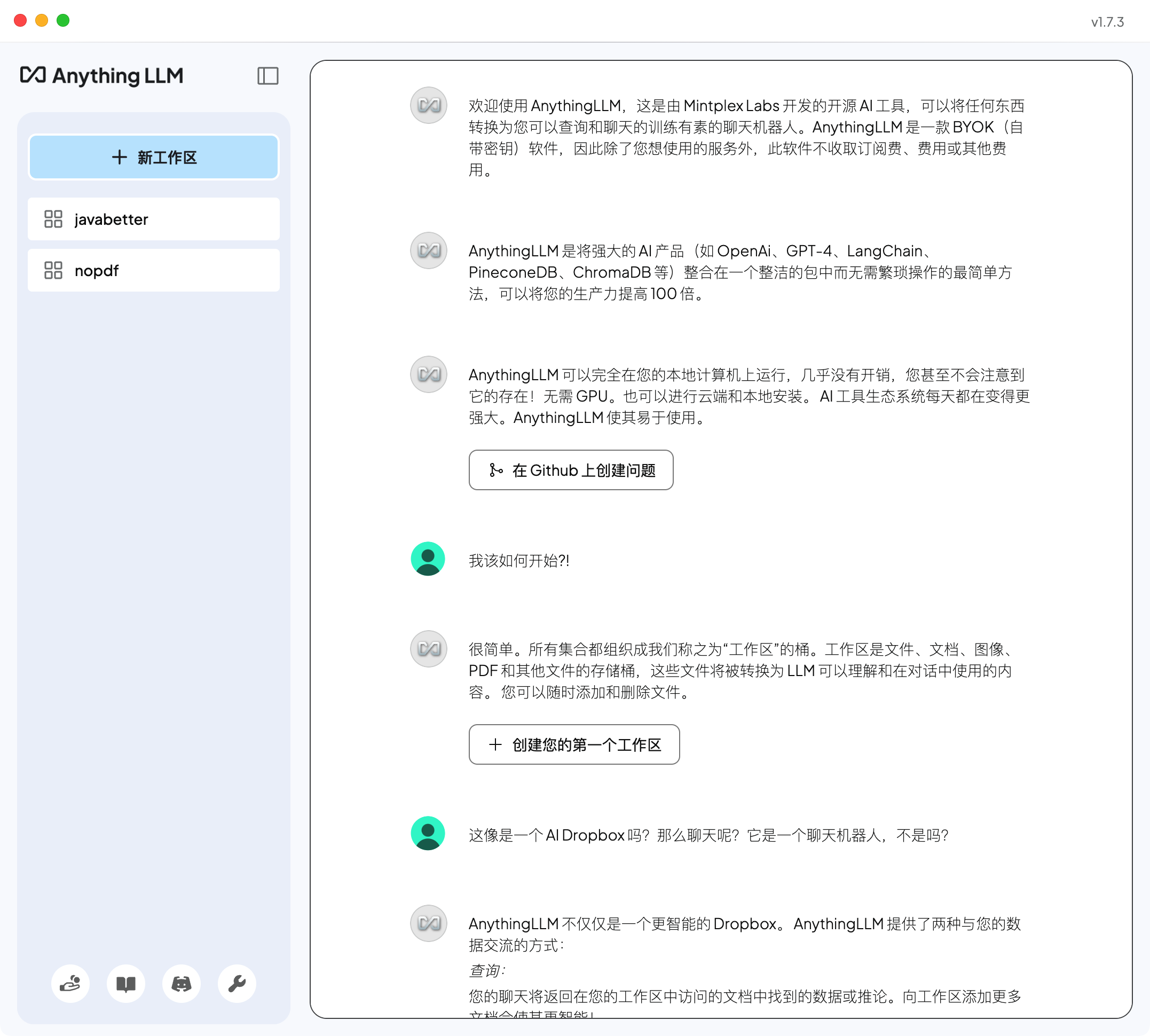

双击运行安装就可以了,打开后的界面如下所示。

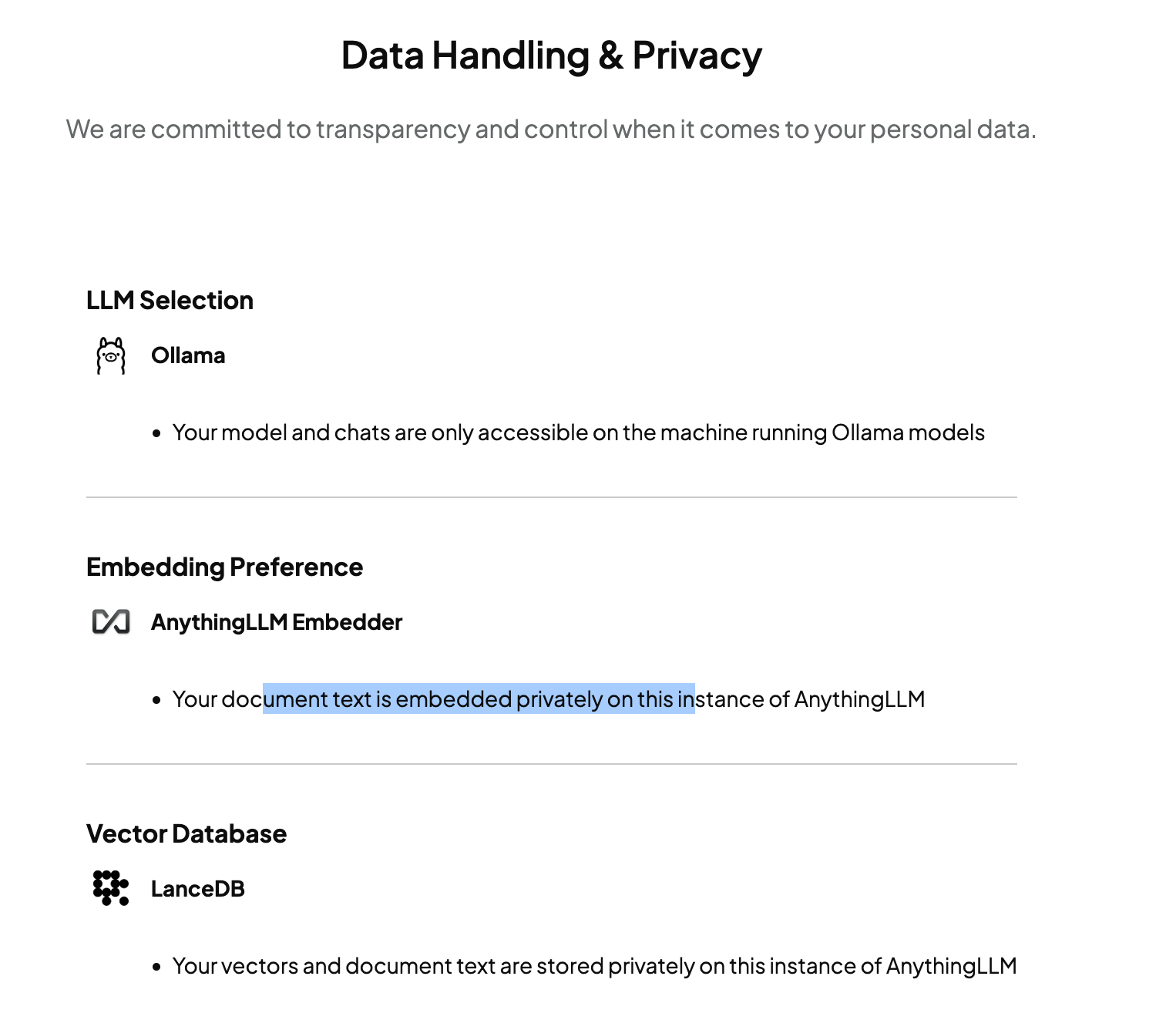

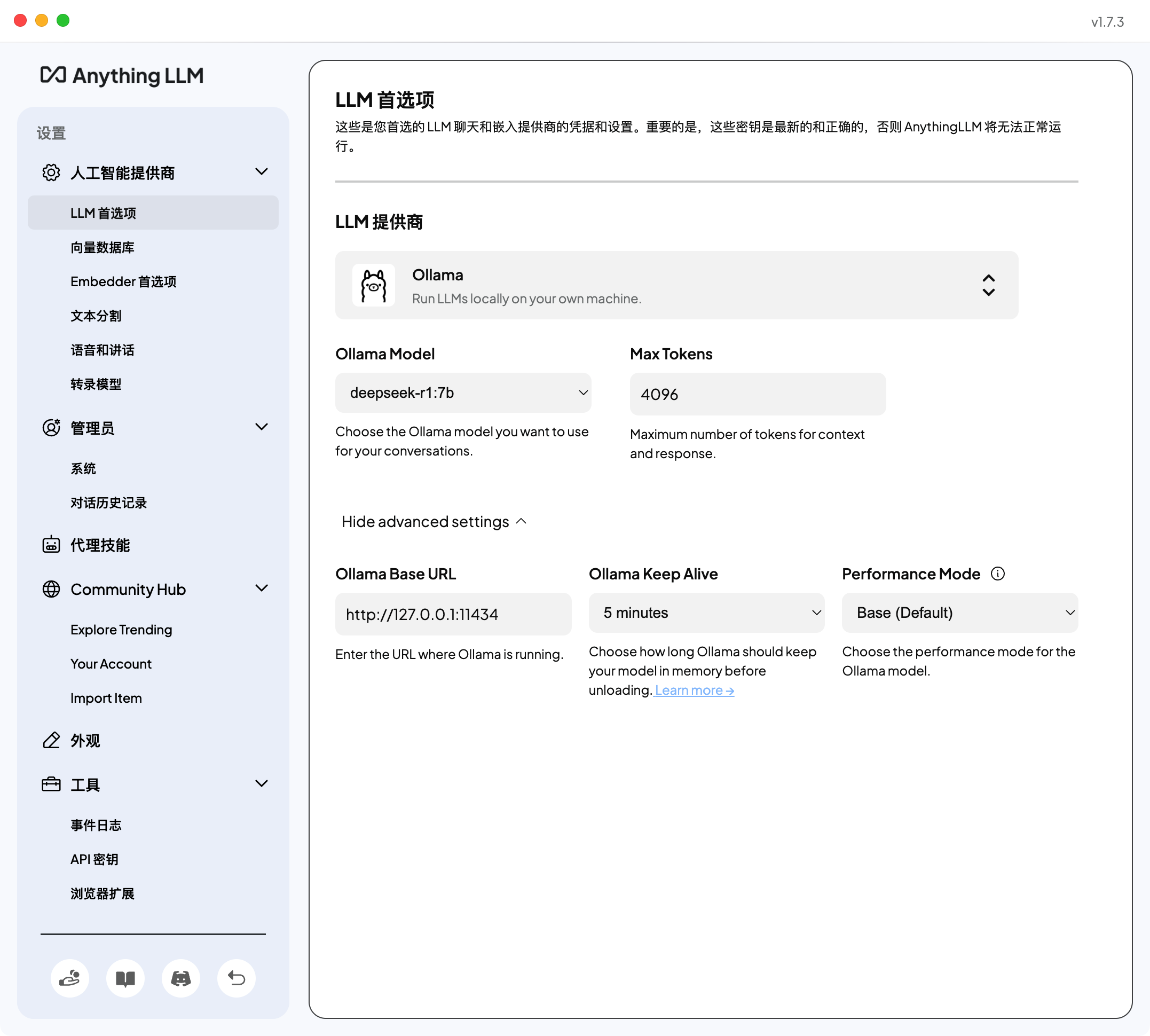

我这里已经配置好了面渣逆袭的 PDF 知识库,如果你是第一次运行,需要在启动过程中选择 ollama。

也就是我们前面搭建好的 deepseek-r1,在设置界面这里也可以配置。

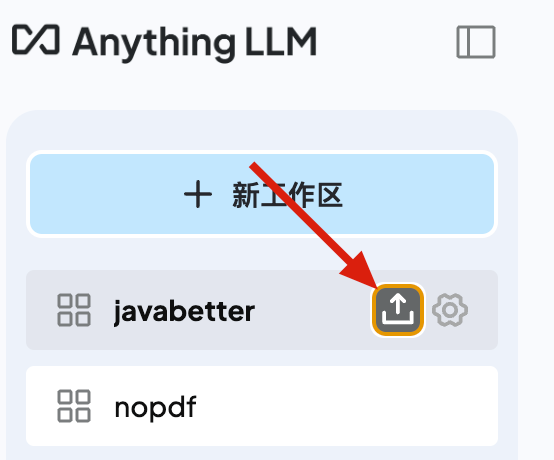

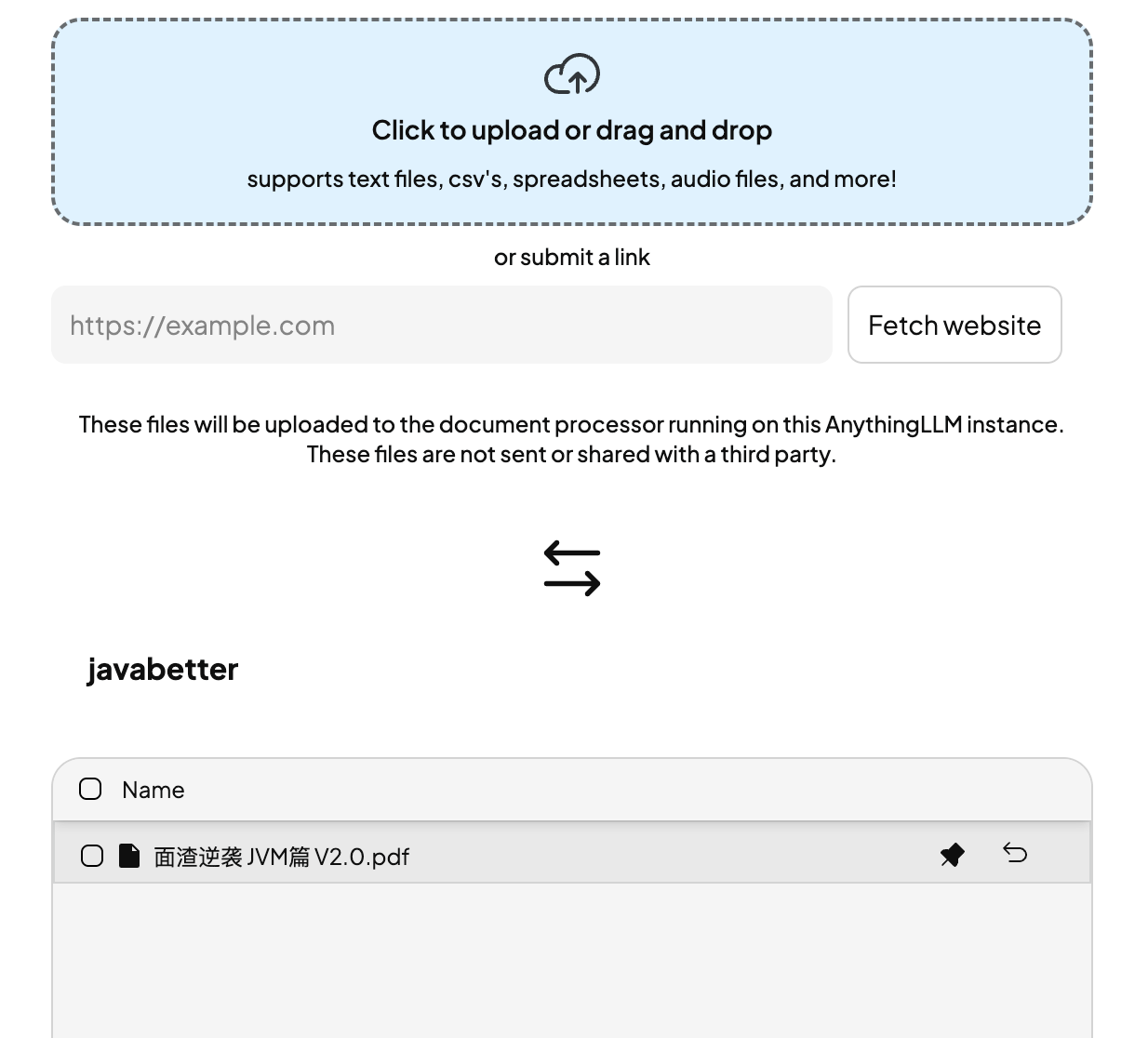

如果想投喂知识库,直接在工作区这里点击【上传】小图标,在弹出的窗口中选择需要上传的文件,如面渣逆袭 jvm 篇。

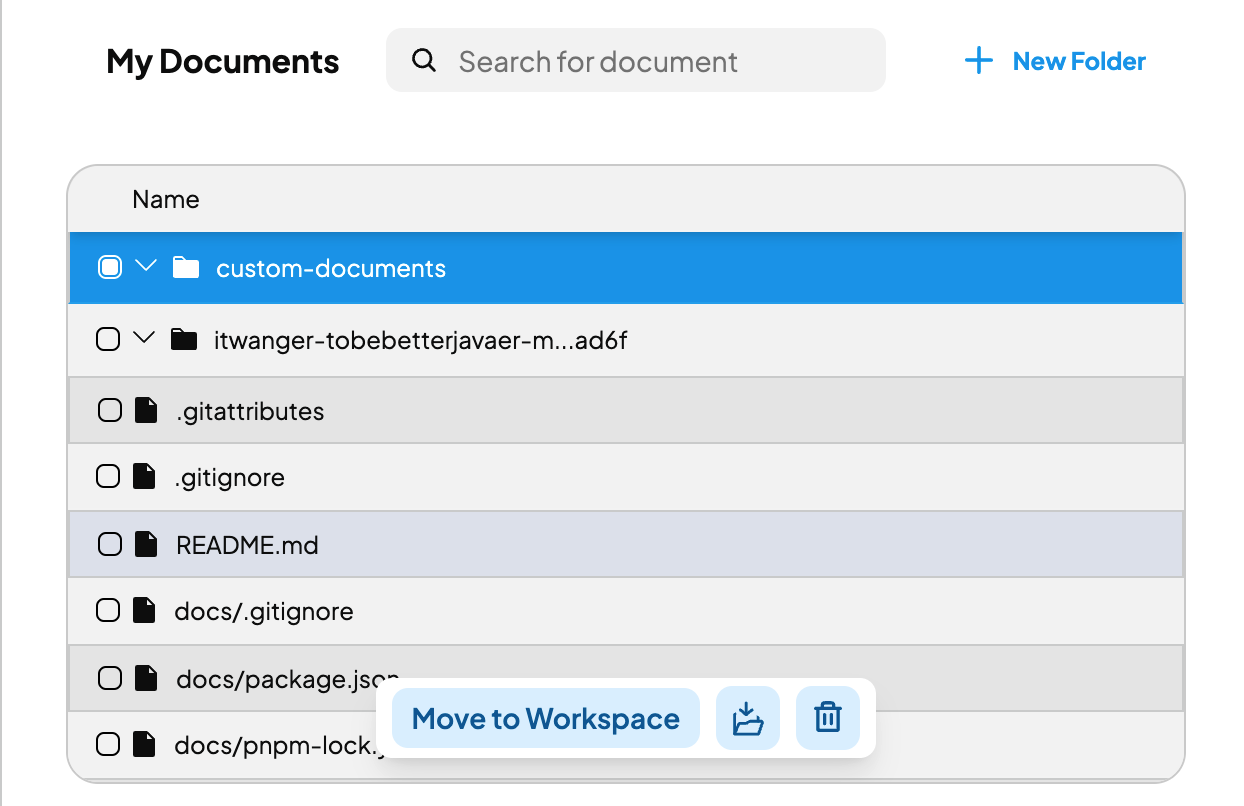

我这里已经上传过了,你还可以通过网页的形式,或者 GitHub 仓库的形式给 deepseek 投喂数据。

比如说,我这里选择投喂了二哥的 Java 进阶之路 GitHub 仓库。

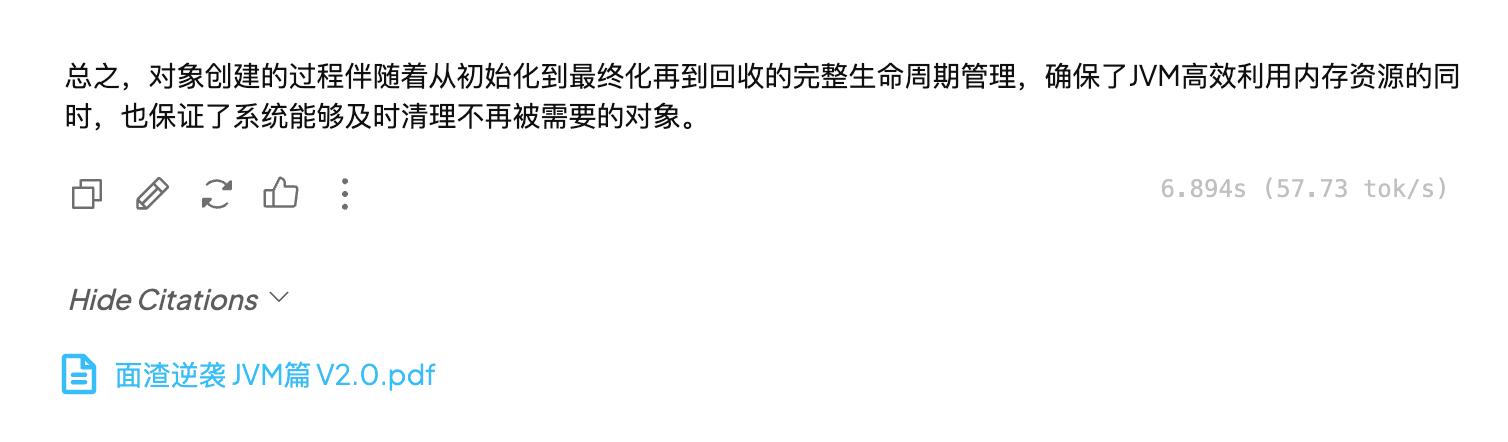

完事后,我们就可以在聊天窗口里进行提问了,比如我问“对象创建的过程了解吗?”

就可以通过 deepseek 进行推理回答了。

可以看到推理过程,以及结果。

点开底部的 show citations 还可以看到我们刚刚投喂的PDF。

我们还可以在设置这里配置查询还是聊天模式,查询模式的话,就是主要基于知识库给出结果,聊天的话,如果你问的数据在知识库中是没有的,大模型可能会胡编乱造一些给你,这里一定要注意。

到此为止,在本地搭建属于你自己的知识库,就算是完成了。

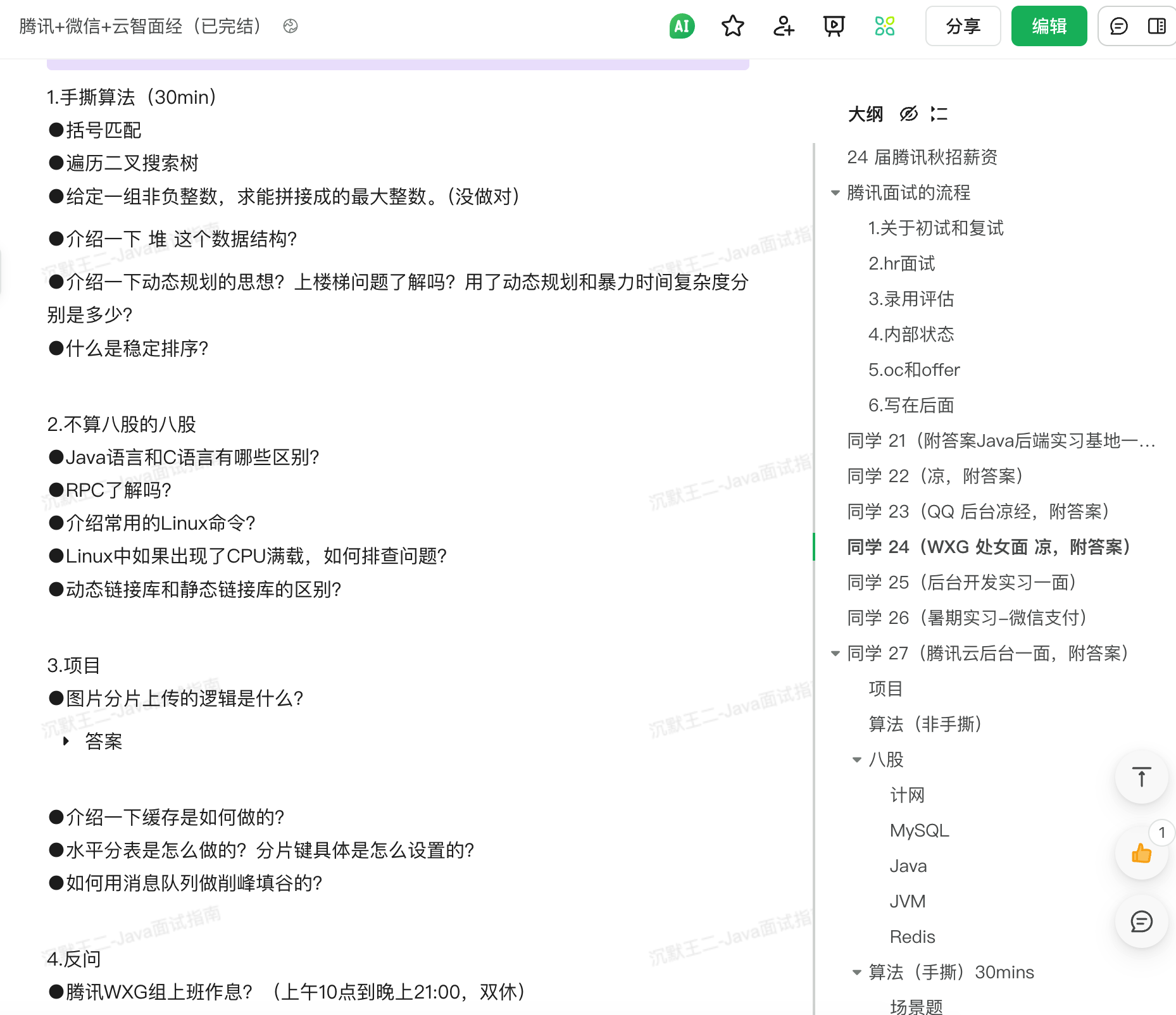

如果有球友想通过这种方式快速消化掉《Java 面试指南》中的大厂面经,就可以通过这种方式来完成。

比如说,你可以拿腾讯的面经,通过本地知识库来进行检索查询答案。

然后从面渣逆袭中快速 get 到对应的结果。

学习的效率就能翻倍了。

小结

蛇年,最火的主题就是 deepseek,这段时间,网上铺天盖地都是 deepseek 的信息,甚至割韭菜的,希望大家不要成为工具的受害者。

其实,对于我们普通人来说,压根不用去买课,就能搭建一套属于自己的本地知识库,还非常简单。

热门评论

3 条评论

回复